HBM이란? 차세대 메모리 기술 비교와 성능 분석

HBM: 고대역폭 메모리의 구조와 발전사

1. 개요

High Bandwidth Memory(고대역폭 메모리, HBM)는 대한민국의 SK하이닉스가 최초로 개발하고 2013년에 발표한 적층형 메모리 규격입니다. 기존의 GDDR 계열 메모리를 대체하며, 더 높은 대역폭을 제공하기 위해 설계되었습니다. 이 글에서는 HBM의 구조, 역사, 장단점, 그리고 다른 메모리 규격과의 성능 비교를 다룹니다.

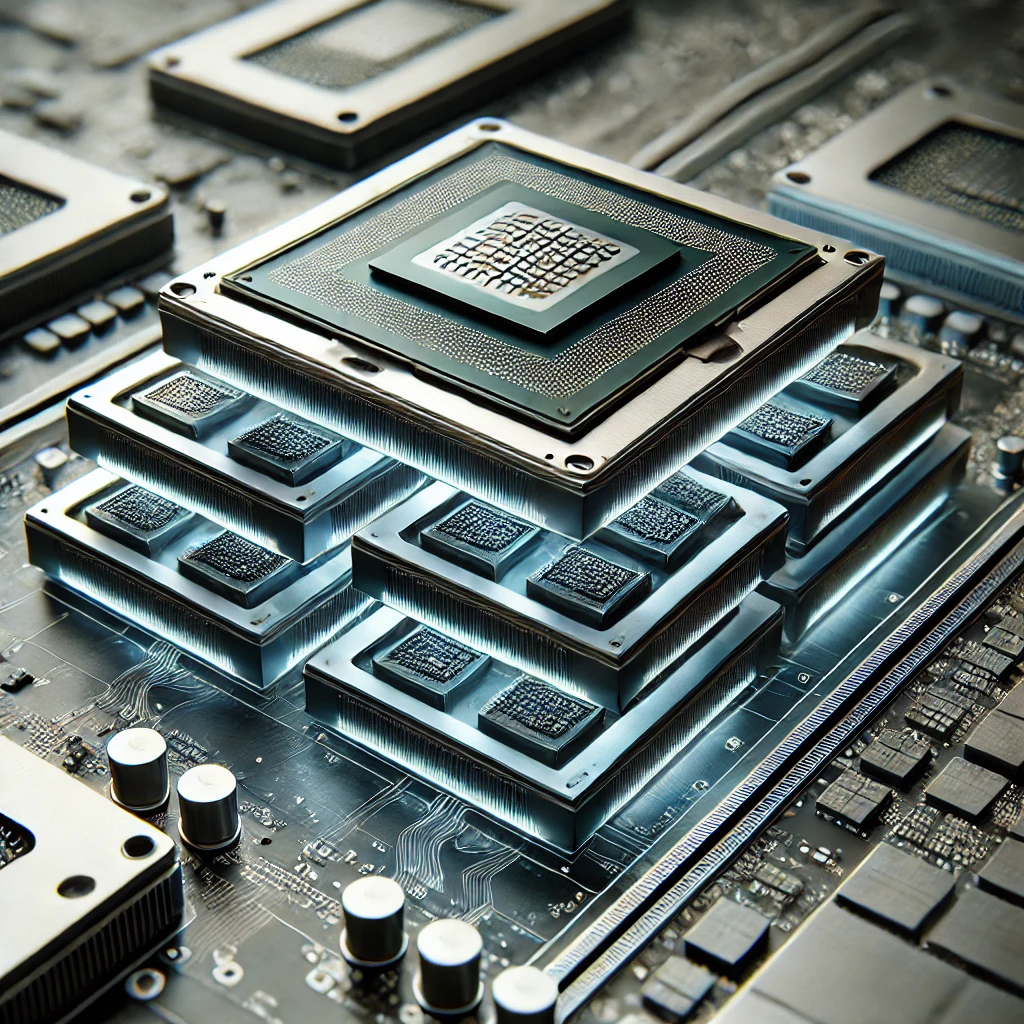

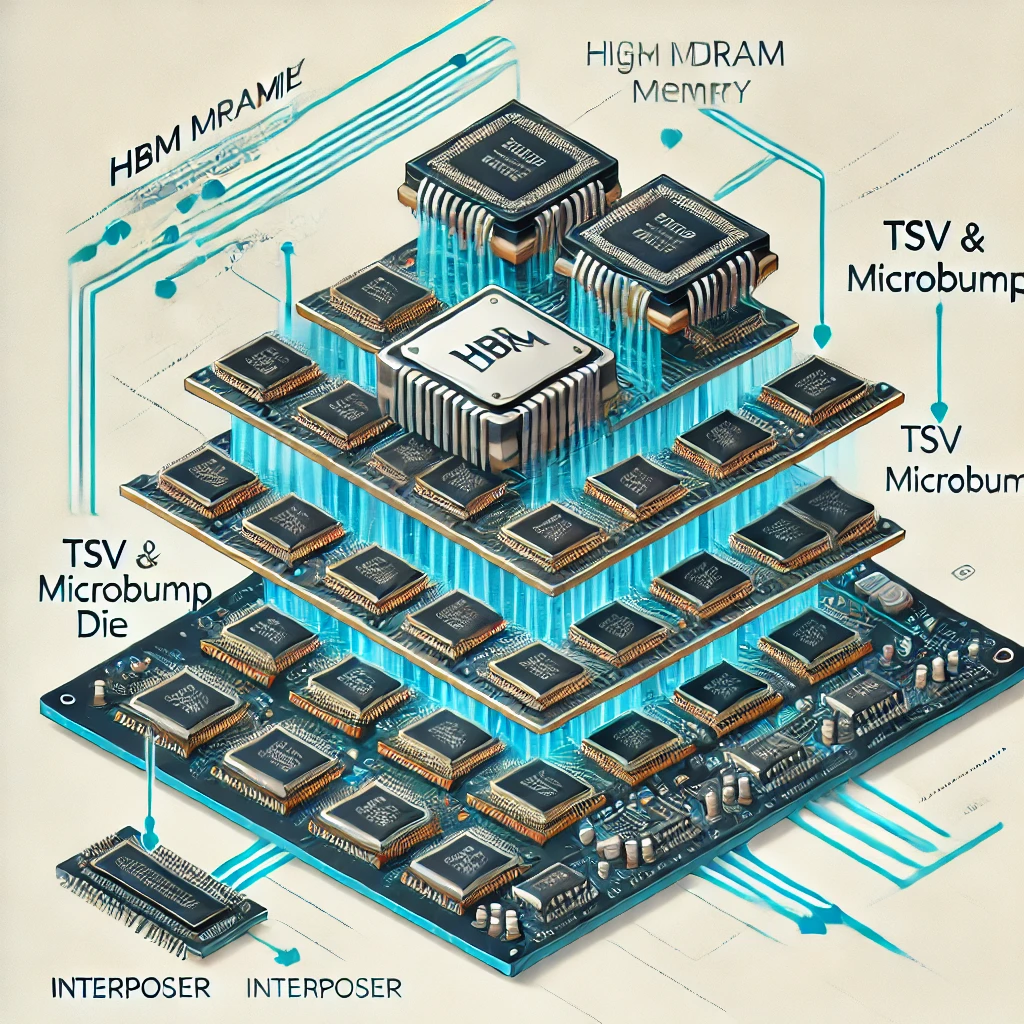

2. 구조

HBM은 기존의 GDDR 계열 메모리를 대체하기 위해 개발되었습니다. 메모리 다이를 적층하고, 이를 통해 주 프로세서와 통신하는 방식으로 설계되었습니다. GDDR이 인쇄 회로 기판에 직접 연결되는 반면, HBM은 인터포저라는 중간 단계를 필요로 합니다. 인터포저를 통해 GPU와 HBM을 가깝게 배치하여 연결하는 방식입니다.

2.1. 규격

HBM은 JEDEC 표준 규격을 따릅니다. HBM1부터 HBM3E까지 여러 버전이 있으며, 각 버전마다 채널 구성, 스택당 다이 구성, 최대 용량, 전압, 클럭, 대역폭 등이 다릅니다.

규격총 채널 구성스택당 다이 구성스택당 최대 용량(GB)전압(V)클럭(비트레이트)채널당 I/O 데이터 전송률스택당 대역폭(GB/s)

| HBM | 8 채널 x 128-bit x 4-Hi | 4 | 1024-bit | 1.3 | 500 MHz (1 Gbps) | 1 GT/s | 128 |

| HBM2 | 8 채널 x 128-bit x 8-Hi | 8 | 1024-bit | 1.2 | 1000 MHz (2 Gbps) | 2 GT/s | 256 |

| HBM2E | 8 채널 x 128-bit x 12-Hi | 24 | 1024-bit | 1.2 | 1200 MHz (2.4 Gbps) | 2.5 GT/s | 307 |

| HBM3 | 16 채널 x 64-bit x 16-Hi | 64 | 1024-bit | 1.1 | 3200 MHz (6.4 Gbps) | 6.4 GT/s | 819 |

| HBM3E | 2023년 | 미정 | 미정 | 미정 | 미정 | 미정 | 미정 |

3. 역사

HBM은 초기에는 GDDR에 비해 우세하지 못한 성능으로 인해 관심을 받지 못했습니다. 그러나 시간이 지나면서 성능 개선이 이루어졌고, GDDR과 HBM 간의 기술 격차가 점점 벌어졌습니다. 특히 인공지능 분야에서의 수요 증가로 인해 HBM의 중요성이 부각되고 있습니다.

3.1. 2021 ~ 2022년

2021년 SK하이닉스는 HBM3 개발 소식을 발표하였고, 2022년에는 HBM3의 JEDEC 표준 사양이 발표되었습니다. 삼성전자도 뒤늦게 HBM3 개발에 착수하였고, 2022년에는 HBM3 '아이스볼트'를 개발하였습니다.

3.2. 2023년

2023년에는 SK하이닉스와 삼성전자가 HBM 시장에서 높은 점유율을 기록하였습니다. 특히 SK하이닉스는 HBM3E 개발에 성공하며 시장을 주도하고 있습니다.

3.3. 2024년

2024년에는 SK하이닉스가 16단 HBM3E 기술을 공개할 예정입니다. 이는 16단 48GB에 1.28TB/s의 대역폭을 처리할 수 있는 기술입니다.

4. 장점

짧은 레이턴시와 높은 메모리 대역폭

HBM은 짧은 레이턴시와 높은 대역폭을 제공합니다. 이는 메모리 다이와 GPU 간의 통신 거리가 짧아 신호 노이즈를 최소화할 수 있기 때문입니다.

작은 칩 면적과 작은 컨트롤러 면적

HBM은 PCB에서 차지하는 메모리 칩의 총 면적을 줄일 수 있으며, 프로세서 내부에 탑재되는 내장 메모리 컨트롤러도 더 작은 편입니다.

낮은 전력 소모

HBM은 전력 소모가 낮아 고성능 GPU에 적합합니다. GDDR에 비해 1/4 수준의 전력 소모량을 보입니다.

유리한 메모리 용량 확장성

HBM은 적층 기술을 통해 용량을 계속해서 늘릴 수 있습니다. 이는 GDDR에 비해 용량 확장성이 뛰어납니다.

HMC보다 쉬운 구현 난이도

HBM은 HMC에 비해 구현 난이도가 낮아 대량 생산이 용이합니다. 또한, 프로세서 위에 직접 적층하는 것이 아닌 인터포저를 통해 구현되므로, 더 쉽게 사용할 수 있습니다.

5. 단점

높은 제작 난이도와 낮은 수율

HBM은 DRAM 다이를 높이 쌓아 연결해야 하기 때문에 제작 난이도가 높고, 수율이 낮습니다. SK하이닉스는 수율이 80%에 육박하지만, 다른 제조사는 수율이 30~50%에 불과합니다.

높은 완제품 구현 난이도

HBM은 기판에 직접 붙이는 GDDR과 달리 인터포저를 필요로 합니다. 이로 인해 구현 난이도가 높아지고, 비용이 증가합니다.

비싼 가격

HBM은 GDDR에 비해 가격이 비쌉니다. 예를 들어, HBM3의 1GB 가격이 약 15달러로, 16GB 칩셋 하나가 33만원에 달합니다.

복잡한 구조와 낮은 내구성

HBM은 구조가 복잡하여 내구성이 낮고, 고장 시 수리가 어렵습니다.

낮은 메모리 클럭과 낮은 오버클럭 마진

HBM은 대역폭이 넓지만 동작 속도가 낮고, 오버클럭에 따른 발열 증가로 인해 성능 향상에 한계가 있습니다.

6. 타 규격과 성능 비교

6.1. 칩당 대역폭

기준년도구분핀 개수속도대역폭차이

| 2014년 | GDDR5 | 32 | 9Gbps | 36GB/s | 약 3.56배 |

| HBM1 | 1024 | 1Gbps | 128GB/s | ||

| 2018년 | GDDR6 | 32 | 18Gbps | 72GB/s | 약 4.26배 |

| HBM2 | 1024 | 2.4Gbps | 307GB/s | ||

| 2020년 | GDDR6X | 32 | 21Gbps | 84GB/s | 약 5.48배 |

| HBM2e | 1024 | 3.6Gbps | 460GB/s | ||

| 2022년 | GDDR6X | 32 | 24Gbps | 96GB/s | 약 8.53배 |

| HBM3 | 1024 | 6.4Gbps | 819GB/s | ||

| 2024년 | GDDR7 | 32 | 32Gbps | 128GB/s | 약 9.24배 |

| HBM3e | 1024 | 9.2Gbps | 1.15TB/s |

6.2. 그래픽카드 제품별 대역폭

기준년도제품명구분칩 개수대역폭

| 2020년 | 엔비디아 RTX3090 | GDDR6X | 24개 (24GB) | 936GB/s |

| 엔비디아 RTX A6000 | GDDR6 | 24개 (48GB) | 768GB/s | |

| 엔비디아 A100 | HBM2e | 6개 (80GB) | 2TB/s | |

| 2022년 | 엔비디아 RTX4090 | GDDR6X | 12개 (24GB) | 1TB/s |

| 엔비디아 H100 PCIe | HBM2e | 6개 (80GB) | 2TB/s | |

| 2024년 | AMD Instinct MI300X | HBM3 | 8개 (192GB) | 5.3TB/s |

| 엔비디아 H200 SXM | HBM3e | 6개 (141GB) | 4.8TB/s | |

| 엔비디아 B200 SXM | HBM3e | 8개 (192GB) | 8TB/s | |

| 엔비디아 RTX5090(예상) | GDDR7 | 16개 (32GB) | 2TB/s |

댓글